Sten-Åke Sändh

Aktiv medlem

Effektivisera metadatasättning

XMP-metadatasatta bilder kan vara till en enorm hjälp när man vill effektivisera sin bildhantering men att metadatasätta stora mängder bilder kräver sin tid och många har börjat men de flesta ger upp efter ett kort tag då de inte tycker sig har tid. Därför är det många som nu sneglar mot AI för att slippa detta arbete.

Automatisk bildanalys har de senaste åren blivit allt bättre men frågan är ju om den är tillräckligt bra för att anförtros att att exv. automatiskt skriva in Keywords, Descriptions och även Headlines?

Vill vi verkligen automatisera "keywording" med AI?

På PhotoMechanic Forum kan man nu läsa "feature requests" om att man vill få Camerabits att plugga in ChatGPT så den kan hjälpa till med att metadatasätta exv. keywords med automatisk bildanalys.

OpenAI Announces Chat GPT-4, an AI That Can Understand Photos | PetaPixel

Jag var lite elak när jag testade med en bildlänk till en bild jag har på Fotosidan

När jag klistrade in nedanstående länk till denna bild i ChatGPT kom följande text ut:

Fråga: What do you see in this picture? https://sten-ake-sandh.fotosidan.se/viewpic.htm?ID=3691317

"The picture at the link you provided appears to be a close-up photograph of a flower, specifically a pink peony. The image is focused on the center of the flower, which is composed of several layers of petals arranged in a circular pattern around a central core. The petals are a vibrant pink color with a delicate texture, and they are tightly clustered together in the center of the flower. The center of the flower is also interesting, with a cluster of yellow stamens and a green pistil in the middle. Overall, it's a beautiful and detailed photograph of a peony flower."

Min slutsats är att jag aldrig skulle låta Open AI grisa ner mina metadata hur smidigt det än kan vara vid en första påsikt.

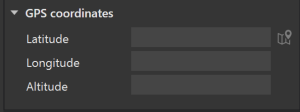

Automatiskt metadatasätta med hjälp av GPS-koordinater

Däremot har jag metadatasatt en hel del bilder med GPS-koordinater i PhotoMechanic Plus och det är jag imponerad av på flera sätt. PM har ett jättebra verktyg för att pricka ut platsen där bilden är tagen. Dessutom kan man med "Reverse look up" exv. automatiskt få en massa metadatafält relaterade till koordinaterna ifyllda. Den tjänsten tog det ett tag för mig att upptäcka men nu använder jag den jämt. Det är till skillnad från den förra tjänsten något som verkligen verkar funka - men det är ju inte AI utan bara en smart databasbaserad tjänst.

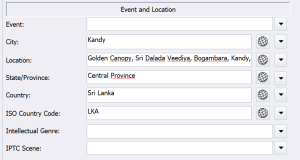

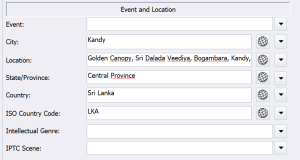

Här en bild från Temple of the tooth i Kandy Sri Lanka

Om man vill läggs upp till 11 IPTC-fält med geodata in baserat på var markören sätts på kartan på alla bilder man markerat. I mitt fall underhåller jag bara fem av dessa fält via mina mallar men de andra fälten uppdateras också även om det inte syns i mina mallar. Kvaliteten blir också högre på detta data normalt än när jag skriver in denna data manuellt själv och det går klart fortare.

Jag tror Chat GPT har en rätt lång väg att gå innan den blir lika pålitlig som ett databasbaserat stödsystem. Jag kommer heller aldrig låta någon bildtolkningstelefonlogik grisa ner mina bilder och mitt keywordregister, även om det säkert är praktiskt. Kvaliteten är helt enkelt för dålig.

XMP-metadatasatta bilder kan vara till en enorm hjälp när man vill effektivisera sin bildhantering men att metadatasätta stora mängder bilder kräver sin tid och många har börjat men de flesta ger upp efter ett kort tag då de inte tycker sig har tid. Därför är det många som nu sneglar mot AI för att slippa detta arbete.

Automatisk bildanalys har de senaste åren blivit allt bättre men frågan är ju om den är tillräckligt bra för att anförtros att att exv. automatiskt skriva in Keywords, Descriptions och även Headlines?

Vill vi verkligen automatisera "keywording" med AI?

På PhotoMechanic Forum kan man nu läsa "feature requests" om att man vill få Camerabits att plugga in ChatGPT så den kan hjälpa till med att metadatasätta exv. keywords med automatisk bildanalys.

OpenAI Announces Chat GPT-4, an AI That Can Understand Photos | PetaPixel

Jag var lite elak när jag testade med en bildlänk till en bild jag har på Fotosidan

När jag klistrade in nedanstående länk till denna bild i ChatGPT kom följande text ut:

Fråga: What do you see in this picture? https://sten-ake-sandh.fotosidan.se/viewpic.htm?ID=3691317

"The picture at the link you provided appears to be a close-up photograph of a flower, specifically a pink peony. The image is focused on the center of the flower, which is composed of several layers of petals arranged in a circular pattern around a central core. The petals are a vibrant pink color with a delicate texture, and they are tightly clustered together in the center of the flower. The center of the flower is also interesting, with a cluster of yellow stamens and a green pistil in the middle. Overall, it's a beautiful and detailed photograph of a peony flower."

Min slutsats är att jag aldrig skulle låta Open AI grisa ner mina metadata hur smidigt det än kan vara vid en första påsikt.

Automatiskt metadatasätta med hjälp av GPS-koordinater

Däremot har jag metadatasatt en hel del bilder med GPS-koordinater i PhotoMechanic Plus och det är jag imponerad av på flera sätt. PM har ett jättebra verktyg för att pricka ut platsen där bilden är tagen. Dessutom kan man med "Reverse look up" exv. automatiskt få en massa metadatafält relaterade till koordinaterna ifyllda. Den tjänsten tog det ett tag för mig att upptäcka men nu använder jag den jämt. Det är till skillnad från den förra tjänsten något som verkligen verkar funka - men det är ju inte AI utan bara en smart databasbaserad tjänst.

Här en bild från Temple of the tooth i Kandy Sri Lanka

Om man vill läggs upp till 11 IPTC-fält med geodata in baserat på var markören sätts på kartan på alla bilder man markerat. I mitt fall underhåller jag bara fem av dessa fält via mina mallar men de andra fälten uppdateras också även om det inte syns i mina mallar. Kvaliteten blir också högre på detta data normalt än när jag skriver in denna data manuellt själv och det går klart fortare.

Jag tror Chat GPT har en rätt lång väg att gå innan den blir lika pålitlig som ett databasbaserat stödsystem. Jag kommer heller aldrig låta någon bildtolkningstelefonlogik grisa ner mina bilder och mitt keywordregister, även om det säkert är praktiskt. Kvaliteten är helt enkelt för dålig.

Senast ändrad: