Personligen föredrar jag att lägga in nyckelord själv när jag importerar bilder till Lightroom (inte molnversionen). Jag har inga problem att hitta mina bilder med den metoden, men gillar man att pilla med AI-promptar och sånt kan det förstås vara kul i sig ...

Jag har idag slutbehandlat bilder från 52 olika resmål jag varit på och en hel del annat också (totalt ca 20 000 färdigbehandlade bilder) och jag har många kvar inklusive odigitaliserade dian och skulle jag suttit där och pillat med allt manuellt så är nog risken stor att jag skulle kroknat för länge sedan. Jag har varit verkligt trött på den halvmanuella hjärndöda process jag tidiagre haft med PhotoMechanic där Description och Keywords oftast varit helt manuellt.

Så när jag fattade vad man verkligen kunde åstadkomma automatiskt med iMatch så var beslutet att migrera för ett år sedan en icke-fråga. Det funkade helt enkelt inte längre för mig med PhotoMechanic nu och att bygga ett bildarkiv med Lightroom var det första jag gav upp (för mer än 10 år sedan) för de verktygen var rent usla även i jämförelse med PhotoMechanic.

Nä grejen är ju att jag aldrig pillar med AI-promptar längre för Keywords. Den prompten är i princip statisk när man gjort den som funkar bra för ens behov.

Det är även så att iMatch har en massa avancerade funktioner för att sortera dem och formatera dem - Stor begynnelsebokstav eller bara gemener eller vad man nu vill ha.

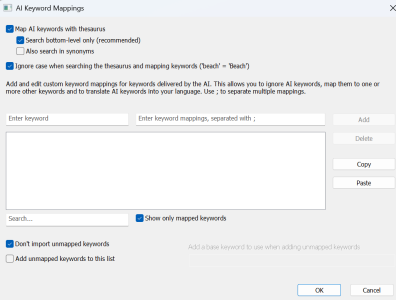

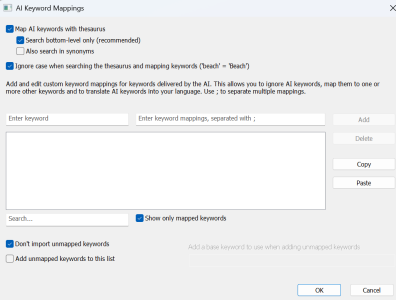

Det är ofta heller ingen bra idé att helt släppa AI lös med Keywords. Jag har även begränsat antalet till 7. Det jag gjort är att importera keywords initialt från de jag redan använt på mina 20 000 färdiga bilder. Sedan matchar iMatch automatiskt så att bara de keywords AI föreslår som matchar de ord som redan finns i min s.k. "Thesaurus" eller "controlled vocabulary" i iMatch skrivs in och inget annat. På så sätt vidmakthålls integriteten i databasen och i Thesaurus. Det händer sedan att jag kan öppna den tillfälligtvis om jag vet att jag ska processa djurbilder jag aldrig läst in tidigare - men det är ett undantag.

Nedan ser ni detta gränsnitt som man styr mappningen ifrån.

Nedan den Keywords-prompt jag tagit fram för mina behov.

[[-c-]]

Never ever write hieracical Keywords with pipe characters like in Flowers|Grass

Keywords never in plural form

Maximum 7 Keywords

Use simple English, common words, factual language.

Preferably just one ord in each keyword with the only exeption when writing name on Animal or Plant names

Never write name of places, country or year in keywords

No words with only capital letters

If there is an animal, flower or plant in the image, write the animal’s, flower's or plant's ["Common name"]

If there is an animal keywords with two words are allowed

If more than one specie write for all species in picture

If it is a Mammal write Animal and Mammal

If it is a Bird write Animal and Bird

If it is a Reptile write Animal and Reptile

If it is a Fish write Animal and Fish

If it is an Insect write Animal and Insect

If it is a Flower write Flower

If it is a Tree write Tree

If it is a Plant write Plant

If it is a Fruit write Fruit

Den enda prompten jag ändrar i är den s.k. Ad-hoc-prompten. Där läggher jag normalt bara på Plats, Land och År, sedan får AI sköta resten medan jag gör något annat en stund.

Den är mycket enklare och kan se ut så här:

Mandatory text to write on the first line of Descriptions: Animals and Vegetation in East Africa - Amboseli Kenya 2014 -