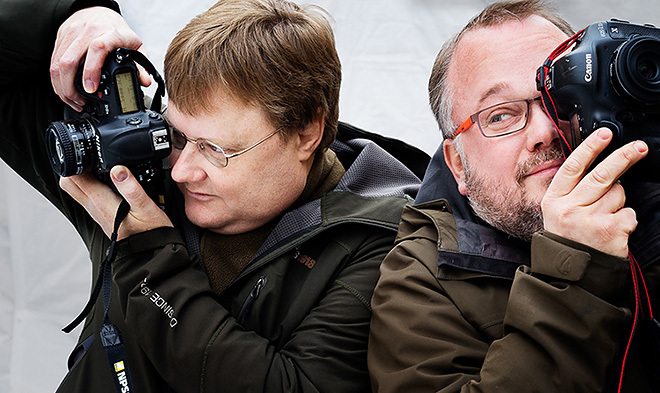

Fotosidan Poddradio

"Älska megapixlarna – och glöm dom" predikar Fotosidans teknikredaktör Martin Agfors. Samtidigt undrar Göran Segeholm om det inte kan bli för många pixlar? Blir det inte mer brus och problem med objektiven?

Canons nya systemkamera, Eos 5Ds, med 50 megapixel väcker många frågor. Göran har pixelångest och söker terapeutisk hjälp hos sin vän Magnus Fröderberg och ingenjören och nörden Martin Agfors.

Några frågor vi tar upp i programmet är:

Blir bildfilerna för tunga för datorn? (05.49)

Ökar bruset med fler pixlar? (07.54)

Vad händer med det dynamiska omfånget? (18.11)

Klarar mina objektiv upplösningen? (23.32)

När ska megapixelracet sluta? (31.45)

Här kan du läsa Martin Agfors artikel om upplösning och pixlar.

Tidigare avsnitt

Avsnitt 10 – Måste man gå fotoutbildning?

Avsnitt 9 – Fotogram - ta snygga bilder utan kamera

Avsnitt 8 – Vilka bilder är bäst? Så resonerar Årets bild-juryn

Avsnitt 7 – Kom igång med gatufoto!

Avsnitt 6 – Så fungerar Creative commons-licenser

Avsnitt 5 – Tips inför kameraköpet 2015

Avsnitt 4 om upphovsrätt och priset på en bild.

Avsnitt 3 om stimulerande fotoprojekt och julklappar åt fotografer

Avsnitt 2 om framtidens kameror och TT:s stora fotopris.

Avsnitt 1 om oskäliga villkor för fototävlingar och om att fotoböcker blivit populära.

Du kan även lyssna på Fotosidans Poddradio genom Itunes.

69 Kommentarer

Logga in för att kommentera

I väldigt generella termer kan man säga att det alltid, oavsett vad man fotograferar, finns en bildkvalitetsmässig fördel att utgå från så mycket insamlad information som möjligt.

Sedan kan man fråga sig hur ofta vi egentligen i praktiken behöver den fördelen, och hur viktig den tekniska bildkvaliteten är för olika bilder, men det är en lite annan diskussion :-)

Tummen upp på att optik alltid är nummer ett, Andreas. Kamerahus kommer och går, god optik består.

Nu var väl det här en nördpodd, och då kan pixlarna och det dynamiska omfånget vara minst lika viktigt ;)

Hör ingen som säger emot ;)

Nej och jag välkomnar också utvecklingen såklart :)

Testa "mouse over" dude ;)

Funkar ju inte på startsidan (och inte på en padda heller för den delen) ;)

När jag nu testade på datan gick det förstås bra :)

Så, som ni säger, glöm ALLTID pixelmängden och fotografera som du alltid gjort. Sluta titta så djupt i "glaset" istället ;-)

Det påstås i podden att ljus rör sig i slumpmässiga banor, jag trodde att ljuset rör sig i en rät linje?

Vidare att man får "störningar under omvandling från analog till digital signal."

-Sker det verkligen sådan omvandling i en digital kamera? Var då i så fall?

Ljuset rör sig i våglängder. beroende på vilken våglängd ljuset rör sig i så uppfattar vi det som olika färger.

Den analoga delen i kameran är fortfarande optiken. Omvandlingen sker när ljuset passerar optiken och till den digitala sensorn. se det som. Optik = Analog. CMOS-sensorer = Digital

Sensorn är till stor del analog. Från pixlarna går en analog signal till en A/D-omvandlare som gör signalen digital. Avståndet mellan pixel och A/D-omvandlare varierar mellan olika konstruktioner. Är signalvägen lång ökar uppkomsten av brus.

Om ljuset: Slarvigt uttryckt av mig, svaret är både ock. Idealt rör sig ljus rakt men i praktiken får du dessutom diverse slumpfenomen på olika nivåer. Det synliga ljuset är bara en ganska liten del av den totala strålningen, och ibland kan till exempel någon del av ljuset som är på väg mot en sensor krocka med eller påverkas av någon annan strålning. Det finns många källor till störningar.

Om analog-omvandling: Sensorn är faktiskt i sig själv analog (och till råga på allt färgblind). Den analoga signalen sensorn fångar in omvandlas till digital i A/D-omvandlare. Traditionellt har dessa suttit utanför själva sensorn, men senaste åren har vi också lösningar där A/D-omvandlingen sker integrerat i sensorn. En av flera fördelar med sådan omvandling är att den analoga signalen som till sin natur är mycket mer störningskänslig färdas kortare väg och påverkas mindre innan den digitaliseras. Plus att man då arbetar med många små parallella A/D-omvandlare, en teknik som verkar introducera mindre brus än få stora A/D-omvandlare.

Nu kanske det är ett stickspår att grotta ned sig i det här, men jag tycker att Martin A i programmet uttrycker sig korrekt. Även om strålgång är deterministisk kommer man aldrig ifrån shot noise, alltså slumpvariationer i hur många fotoner som landar var.

Däremot förstår jag inte samme Martin A i kommentaren här ovan i "ibland kan till exempel någon del av ljuset som är på väg mot en sensor krocka med eller påverkas av någon annan strålning"; ett stycke ljus påverkas inte (i betydelsen styrs om eller ändrar våglängd) av att krocka med något annat stycke ljus, annat än möjligen i mycket extrema situationer som inte uppstår i fotografering.

Men jag kanske missförstår den passagen.

Dan: Jag följde upp ett lite otydligt uttalande med ett annat ungefär lika kryptiskt :-)

I sak håller jag med dig.

Bra Optik först och sedan ett hus med bra upplösning och fullformat sensor.

Har nu fixat optik och sparar nu till ett kamera hus. Ser ut att bli ett D810 om inte Nikon kommer ut med 50 Mpix kamera innan jag har fåt ihop pengarna..

Det är svårare att hitta ett bra spegelöst kamera som klarar trippelexponering som komplement till Systemkameran.

Någonstans har man glömt bort fotografen som kreatör och bildskapare

Vem är denne "man" som har glömt bort fotografen? :-)

Äsch, så illa är det väl inte. Inte mer än när man höll på och filade på framkallningstekniken för att få sina PanF 50 så finkorniga som möjligt. Trots att det gamla Schneiderobjektivet inte var så högupplösande. Nog kan man väl ha kul med tekniken utan att glömma att skapa?

Men, eller kanske just därför, vill jag komma med en synpunkt. På slutet när det pratas om skakningsoskärpa dras en jämförelse med den jättehöga pixeltätheten hos enkla kompaktkameror som vi ju handhåller.

Men om man antar att skakningsoskärpan kommer i första hand (vid normal fotografering) från vinkelförändringar i hur man håller kameran så är det inte pixlar per ytenhet på sensorn som är det relevanta, utan pixlar per bildvinkelenhet. Och då hamnar kompaktkamerorna på ungefär samma täthet som systemkameror, vilket också förklarar varför man verkar kunna använda ungefär samma tumregler. Och det förklarar varför det inte verkar vara dubbelt så svårt att handhålla en 24 Mpix APS-kamera med 35 mm objektiv än en 24 Mpix fullformatare med 50 mm objektiv – vilket det skulle vara, om det var pixeltätheten per sensoryta som var det styrande.

Som jag förstår saken spelar ju bägge sakerna roll: Dels pixlar per bildvinkel, men även själva pixelpitchen i sig själv. Det beror på vilken kamerarörelse vi tittar på.

Vi brottas med en blandning av vinkelförändringar men också förskjutning i x-, y- och z-led. Det är hur som helst ett vanligt argument från Olympus och (numera) Sony när de skall berätta hur bra det är med 5-axlig stabilisering :-)

Tänk på att de mer traditionella stabiliseringssystemen (i synnerhet de tidiga) nästan uteslutande ägnar sig åt att kompensera för förskjutningsskakningar, så jag tror inte riktigt att de utgör en försumbar del av det hela.

Och, om jag får vara lite petig i retur ... :-)

Visst har en 24 mpix aps-c dubbelt så många pixlar per ytenhet som en 24 Mpix småbildssensor - men den har bara 40% fler pixlar per millimeter i någon given riktning (som x- eller y-led). Skall det, sett till förskjutningsskakningar, bli dubbelt så svårt att handhålla aps-c-kameran så behöver den klämma in dubbla antalet pixlar på halva ytan för att ge en dubbel känslighet för rörelser i någon given riktning.

Annorlunda uttryckt: En 48 megapixels aps-c borde vara dubbelt så känslig för förskjutningsskakningar som en 24 Mpix småbildssensor. Och du måste upp till 96 Mpix i en småbildssensor för att den skall bli dubbelt så känslig för förskjutningsskakningar som en 24 Mpix småbildssensor. (Här talar jag alltså enbart om förskjutningsskakningar.)

Varför ska myten om att fler pixlar kräver snabbare slutartider vid handhållet vara så svår att ta död på?....

Tack för svar!

Det är mycket riktigt ett rejält "om" att bara vinkelförändringen skulle vara av betydelse. Jag resonerade att om vi antar att förskjutningsamplituden är storleksordningen 1 mm (gripet ur luften) och objektet man fotograferar är flera meter stort och bildvinkeln är någorlunda normal så kommer förskjutningsoskärpan att ha jämförelsevis liten effekt på resultatet. Gängse tumregel med 1/brännvidden (alt 1/(brännvidden*x)) indikerar också att vinkelskaket normalt dominerar över förskjutningsskakning.

Däremot, om man fotar makro och objektet bara är några centimeter stort, då blir förstås förskjutningsoskärpan påtaglig.

Jag är iofs öppen för att jag kan ha tänkt fel här. Det du skriver om traditionella stabiliseringssystem är onekligen bestickande.

Angående upplösning i en eller två dimensioner sedan - jag funderade ett ögonblick innan jag skrev föregående kommentar på vilket mått jag borde ta, men eftersom jag uppfattade att ni körde areamåttet i podden (alltså pixlar per yta) valde jag samma.

Leif:

Myt och myt. Det beror på vad slutmålet är. Om ens mål är att maximalt nyttja all ny upplösningsförmåga så är det ingen myt.

Leif: För att det delvis är sant. Men bara delvis.

Dels är effekten bara intressant om man verkligen vill utnyttja den ökade potentialen den ökade upplösningen kan ge (vilket man ju många vardagsbilder faktiskt inte bryr sig om).

Dels överdriver helt enkelt många hur stort problemet är. Jag skulle nog säga att man måste upp dubbla linjära upplösningen (alltså fyra gånger fler pixlar på samma yta) för att skillnaden skall synas speciellt tydligt. Plus att problemet ofta överskuggas av andra problem - som att motivet rör sig (de är ju ofta det större problemet) eller att detaljåtergivningen hämmas av brus (när vi skruvar upp iso).

Kort sagt, problemet finns men är inte på långa vägar så stort som många gärna vill göra det till.

Dan: Tack själv, kul att ha en diskussion eftersom det här är en fråga som ofta kommer upp. Jag tycker att du tar upp en bra poäng som ofta glöms bort: att skakningsoskärpa rent generellt faktiskt också har med avbildningsskalan (och därmed ofta avståndet) att göra. Det glöms ofta bort.

Dan och Martin:

Den handhållna fotograferingen efter tumregeln 1/brännvidden kan ju absolut inte bli sämre i takt med att pixelmängden ökar så handhållningsmyten är ju precis lika mycket nys som objektivmyten.

Sen att snabbare tider, stativ samt skarpare och ljusstarkare objektiv alltid har varit, och fortfarande är, en fördel tillhör ju bara den vardagliga kunskapen, oavsett pixelmängd eller filmtyp.

Leif, jag tror du missförstår lite ... För att vara extremt övertydlig och för att säga något jag tror de flesta utgår ifrån: jag har aldrig och kommer aldrig påstå att resultatet blir _sämre_ på grund av högre upplösning - vare sig vi talar objektivprestanda eller skakningsoskärpa. Som absoluta värsta fall får man samma resultat med högre upplösning som med lägre. I de allra övervägande flesta fall får man bättre resultat.

Men med högre upplösning går det verkligen att upptäcka skakningsoskärpa som man inte hade upptäckt med en lägre upplösning. Vilket innebär att det är en faktor som tar bort en liten del av den fördel som den högre upplösningen potentiellt kan ge. Ju högre upplösning vi har, ju mer märks detta.

Någonstans når vi en punkt där det på grund av flera faktorer - som skakningsoskärpa, optiska brister, fokusfel med mera - helt enkelt inte längre lönar sig speciellt mycket att höja sensorupplösningen mer. Varje gång sensorupplösningarna höjs tror många att vi passerat den här gränsen, medan jag hävdar att vi i praktiken har långt kvar dit.

Vad Göran tog upp i podden och vad Dan och jag filosoferat kring är att tumregeln 1/brännvidden inte längre funkar lika bra om man vill få ut så mycket som möjligt av sin mer högupplösta sensor. Inte att det skulle bli _sämre_ på grund av det. Frågan är snarare hur stor del av fördelen som äts upp av detta.

Martin: Hoppas det finns slutartider som är korta nog att klara av jotsarna när dom kommer ;-)

Skämt åsido. Vi är nog aningen överens :-)

Leif: Med tanke på den ångest såpass modesta upplösningar som 36 eller 50 MP förorsakar så kan jag bara gissa hur en del skulle känna inför en jot-baserad sensor :-D

Så det vill till att ha optik och ställa skärpan exakt om man skall ha nytta av den höga upplösningen, sitter man framför skärm och hänförs av detaljer man kan gräva fram i sina bilder kan det givetvis vara intressant. Men som de flesta av oss tittar på våra bilder ställer jag mig ytterst tveksam till att vi kommer att se någon skillnad ens om vi går ned ganska mycket i upplösning. Sedan kan det ju finnas en massa andra anledningar till att man vill ha denna kamera, men jag tror att en av de främsta faktiskt handlar om lyckan att ha "det värsta som går att köpa".

Jag sitter själv i samma träsk, fast där handlar det om optik, jag har några rent ut sagt vansinnigt dyra Leicaglugga och älskar dem. Men skulle jag se någon skillnad på väsentligt billigare glas?

Precis, Alf! 2000x3000 px ger en optimal A4-bild, på gränsen av vad ögat klarar. (10 detaljer per mm) Gör en A3 av samma bild och betrakta på lite längre avstånd. Samma intryck! Större bild, längre avstånd. Det ser bra ut.

Normalbehandlad film gav nätt och jämnt den kvalitén.

Sedan kommer förstås önskemålen om beskärning och att betrakta stora bilder nära. Kraven på megapixlar ökar. Ingen mening att klaga. Tacka och ta emot.

Den stora gåvan tycker jag är höga ISO. Vi som, förgäves, pressat film måste bara älska möjligheten att fortsätta fotografera när solen försvunnit.

Befintligt ljus är numera befintligt mörker.

Älska pixlarna, men ännu mer höga ISO!

Ursäkta min tröghet i skallen.

Kanske lättare att förstå om vi gör tvärt om. Ta en 24 mp-bild och skala upp till 50 eller 100 mp. Det är rätt uppenbart att bilden blir större, men att du inte får fram fler detaljer. Informationsinnehållet (effektiviteten) blir relativt sett lägre ju mer vi skalar upp.

Skalar vi ner till 12 megapixel kan vi behålla nästan samma verkliga upplösning i bilden (detaljåtergivning). Vi behåller innehållet men ökar effektiviteten.

Det finns ingen större anledning att sitta och skala ner sina bilder, men det är så här komprimeringen i vissa filformat jobbar, grovt förenklat.

En variant på förklaring: I en normal bild tagen med en normal kamera är informationstätheten inte så hög. Lite som ett blad i ett linjerat block där du bara skrivit text på varannan rad (en väldigt grov liknelse).

Det gör att du oftast kan skala ned sådana bilder till sisådär halva pixelantalet (skriva på varje rad i blocket) utan att egentligen tappa speciellt mycket information, det enda som händer är att du lagrar (i stort sett) samma mängd information utspridd över en mindre yta.

Att skala ned så är så som Magnus pekar på ungefär motsatsen till att skala upp en bild där du ju rent informationsmässigt bara sprider ut data över en större yta.

Tackar för svaren från båda.

(Har 3 st CP 5400:or) Silkeslena bilder, underliga färger ibland, rakbladsskärpa ibland. I praktiken bör man inte gå över 50 ASA ; )) alltså

stativ och stöd och motivet måste vara någorlunda stilla. Ibland så ramlar allting rätt tex med runstenar som motiv..50 mPix just nu..imorgon 200 mPix ..gränsen uppåt begränsas av hur mycket det går i praktiken att få in de ljuskänsliga elementen på den begränsade ytan som vi har idag...Idag en fysisk sensorsplatta imorgon en virtuell programuppbyggd sensor.. vem vet...allting utvecklas och så skall det vara..

Förmodligen inte i en nära framtid, det av två skäl: Dels att det ger en del tekniska problem (batteriförbrukning, värme, dyrare komponenter), dels för att kameratillverkarna nog gärna segmenterar marknaden i "högupplösta och lite långsamma" och "snabba men lite mer lågupplösta" kameror.

Och den segmenteringen är ju ganska begriplig. Även om det förstås finns de som vill ha både hög upplösning och hög hastighet (t.ex. en del fågelfotografer) så är det nog vanligare att man kombinerar riktigt hög upplösning med eftertänksamt fotograferande (där man får mest utbyte av upplösningen) medan de som bryr sig mycket om snabbhet nog ofta bryr sig lite mindre om upplösningen.

Den per automatik misstänksamma inställningen har troligen mest med skräcken för att det ska försvinna pengar från bankkontot.

Nikon kommer med 100 % säkerhet med ett matchande eller ännu bättre hus i sinom tid.

Exakt! I det stora hela är det inte en underligare eller mer oroande utveckling än att vi idag (i jämförbara kameror) tar fler bilder per batteriladdning, får plats mer fler bilder per minneskort, kan ta fler bilder per sekund eller har mer dynamiskt omfång.

Jag misstänker att mycket av misstänksamheten mot fler pixlar uppstår ur bildtittande i 100% och misstolkningar av det man ser där.

Diffraktion är en av flera faktorer, tillsammans med saker som fokusfel, kameraskakningar och optiska brister som gör att ökningen i detaljrikedom i bilderna inte är linjär med ökningen av pixlar - engelskans "diminshing returns". Annorlunda uttryckt: För varje ökning av antalet pixlar får vi gradvis mindre och mindre belöning i form av ökad detaljrikedom i den slutliga bilden. Till slut når man en punkt där fler pixlar i praktiken helt enkelt inte ger mer detaljrikedom.

Nu ger fler pixlar också andra fördelar än ökad detaljrikedom, som ökat dynamiskt omfång. Fler pixlar handlar alltså inte bara om högre upplösning.

Sedan är det med diffraktion ungefär som med kvalitet med optiken eller skakningsoskärpa: En mer högupplöst sensor är mer avslöjande än en sensor med lägre upplösning, men bilden blir aldrig sämre - som allra sämsta utfall får man ingen märkbar kvalitetsökning av fler pixlar.

Ofta ser man uttrycket att den och den sensorn är "diffraktionsbegränsad" vid en viss bländare. Det uttrycket är delvis missvisande, det handlar inte om en hård "begränsning" utan om en gråzon där diffraktionens effekter gradvis märks mer och mer.

Kort sagt, diffraktion är inte en så stor stötesten för ökad sensorupplösning som många vill göra de till. Kompaktkamerorna är ju ett bra exempel, de är ofta helt klart "diffraktionsbegränsade" men det innebär ju inte att kompakter med högre sensorupplösning ger sämre bilder, bara att man inte får ut hela den potentiella fördelen.