Sten-Åke Sändh

Aktiv medlem

Ett test av AI-genererade bildtexter med iMatch Autotagger

Jag har nog under ca ett år använt iMatch DAM (Digital Asset Management) för att hantera mina bilder. Under de senaste månaderna har jag experimenterat en hel del med de dedikerade promptar som finns i iMatch. Det finns alltså tre som oftast är rätt statiska efter att man arbetat fram promptar som fungerar för ens bilder och ens preferenser. Det finns en för "Descriptions", en för "Keywords" och en för s.k. "Landmarks". Utöver det finns även en Ad-hoc-prompt som är till för att lägga på specifik metadata för ett urval bilder.

Meningen med denna tråd för min del är att visa vad man faktiskt kan åstadkomma nu med de bästa och största AI-modellernas API:er som det finns fördefinierade gränssnitt för i iMatch Autotagger.

Den molntjänst som använts i detta fall är Open AI API för GPT 5.2 som just släppts unden december 2025.

Inget kan idag mäta sig med Open AI och Google Gemini.

Jag har testat även franska Mirage AI 3.1 men den håller i dessa fall inte alls samma klass och ger klart sämre resultat.

Jag har alltså autogenererat bildbeskrivningar i detta fall för två typer av bilder och deras s.k. "Descriptions".

Bilderna är rakt ut ur iMatch AS IS och har inte editerats eller rättats.

Detta för att ni ska kunna få en uppfattning om vad man faktiskt kan göra och vilken kvalitet man kan få på texterna.

AI-genererade texter blir inte bättre än prompningen - principen som man frågar för man svar gäller.

För att generera AI-texterma (160 stycken) och skapa två Portfolios och läsa in bilderna samt skapa denna tråd på FS så har jag lagt ner ca två timmar.

Om jag skulle gjort detta manuellt vilket man måste i exv. PhotoMechanic, som många fotografer använder, så hade det nog tagit dagar att få till dessa texter och jag hade aldrig orkat skapa texter med den kvalitet som Autotagger och Open AI faktiskt får till med hyfsat god promptning. Jag har ju heller inte de kunskaper som ligger bakom speciellt texterna kring arkitekturen.

Nedan kan ni se hur den prompt ser ut som jag förfinat fram till idag.

Som ni kan se i bildtexterna i de två portfolios jag skapat med exempelbilder, så kan man göra ganska avancerade saker numera i version 5.2

Redan i "blindtester" man nu gör och hittills gjort med GPT 5.2 visar att kvaliteten på det som kommer ur GPT 5.2 ger bättre resultat än om människor skulle gjort arbetena och det går verkligen på bråkdelar av den tid människor skulle klarat av samma jobb på.

I en studie i dagarna nere från Lund så hittade AI-bildtolkning av röntgenbilder tagna på patienter cancer i betydligt fler fall än tränad specialiserad personal lyckades göra och i tidigare stadier av sjukdomen.

Min egen frus cancer missades under ca ett år, vilket ledde till tre stora och mycket besvärliga canceroperationer. Vem vet, all dessa kanske aldrig skulle behövt genomföras om AI-diagnosticering funnits för fem-sex år sedan.

Åter till ämnet:

Längst ned i bildtexterna i varje ser ni en sammanfattning och det som skrivits där kommer från variabler AI har befolkat med text.

Jag har även formaterat texten med tomrader for att öka läsbarheten.

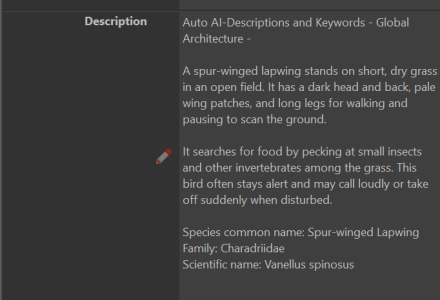

När man ser formatteringen i iMatch så visas texten som nedan:

Även i min RAW-konverterare Photolab 9 behålls formateringen från iMatch perfekt, vilket gör texten betydligt mer läsbar:

I Portfolios så tas alla line feeds bort så allt ligger i en enda röra igen.

Den fösta länken går till en Portfolio jag skapat här på FS som heter "Global Architecture":

Den innehåller ca 60 bilder med arkitekturexempel från ett antal länder.

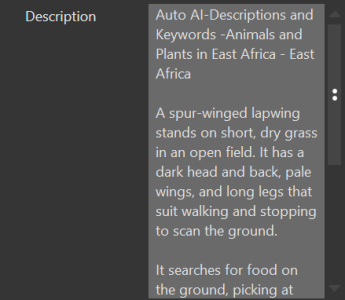

Den andra länken går till en Portfolio med "Animals and Plants from East-Africa"

Den innehåller ca 100 bilder med djur och växter.

I de tester jag gjort med Open AI GPT 5.2 på djur och växt motiv, ca 150 bilder, så fick jag en felprocent på ca 8% sist jag kollade. Det är mycket bra om man jämför med exv. Mistral 3.1 som annars har hyfsat rykte. Dock är Mistral inget bra val idag för att märka upp djur och växtbilder med. Där går den tjänstens gräns för användbarhet.

När det gäller arkitekturbilderna så hade jag förväntat mig mer av Open AI när det gäller "Landmarks". Jag är säker på att Google Gemini 3 eller Flash 2.5 hade klarat "Landmarks" och miljöer bättre. Så varje AI-tjänst har sina egenheter.

OBS!!! De bilder som nu finns under dessa två länkar oven är utbytta mot nya bilder som skapats med den gratis AI-källan Google Gemma 3 12b som körts på den gratis AI-plattformen Ollama. Detta för att testa om det möjligen kan vara möjligt att slippa köra över och vara beroende av de stora amerikanska molntjänsterna Google Gemini och Open AI.

En tidigare mindre modell (Gemma 3 4b) som jag var tvungen att köra då mitt tidigare grafikkort med 8GB VRAM inte klarade den större modellen, klarade INTE att artbestämma djur och växter på dessa bilder. Så hittills har jag för det kört Open AI API medd iMatch DAM.

Glädjande är nu att Gemma 3 12b visar riktigt bra resultat både med att beskriva och klassificera arkitektur och att artbestämma djur och växter men kräver alltså minst 16 GB VRAM. Detta är viktigt att påpeka då priset för de nya 16GB-korten ligger upp mot 10 000, så för många kommer det vara utom räckhåll och då är enda alternativet att köra molntjänsterna som kräver mycket mindre av lokal dator.

Description Prompt i Autotagger

[[-c-]]

General instruction:

Always priority for geografic data in the first line and than add a space, the year the picture is taken and peoples names.

{File.Persons.Label.Confirmed|hasvalue:These persons are shown in this image: {File.Persons.Label.Confirmed}.}

Always write text inside quotes but without the quote signs.

Always translate and write texts on signs into English.

Describe picture in a casual and vivid style.

Use simple English, common words, factual language, and simple sentences.

Avoid describing anything not directly observable in the image.

Always write the Description in 3 paragraphs.

Separate paragraphs with a blank line (i.e., exactly two line breaks between paragraphs).

Do not use bullet lists.

Animal section:

If animals in picture always include a description of the animals appearance, habitat, diet, behaviors, and any unique characteristics.

Consider adding notable facts or interesting trivia about this species. Always add space before

If there is an animal, flower or plant in the image, write the animal’s, flower's or plant's common name, family name, and scientific (Latin) name in the format below and always as the last three lines of text – after the space:

Species common name: [Species common name]

Family: [Family name]

Scientific name: [Latin name]

Else never write anything you don´t see in the picture. Return nothing.

Achitecture section:

If there is architecture in the picture:

Describe the architectures characteristics with an architects professional concepts even important details of facades elements e.t.c. and the time when it was most popular

End with – after a space:

Architecture type or style: [Architecture style or Architecture type]

Jag har nog under ca ett år använt iMatch DAM (Digital Asset Management) för att hantera mina bilder. Under de senaste månaderna har jag experimenterat en hel del med de dedikerade promptar som finns i iMatch. Det finns alltså tre som oftast är rätt statiska efter att man arbetat fram promptar som fungerar för ens bilder och ens preferenser. Det finns en för "Descriptions", en för "Keywords" och en för s.k. "Landmarks". Utöver det finns även en Ad-hoc-prompt som är till för att lägga på specifik metadata för ett urval bilder.

Meningen med denna tråd för min del är att visa vad man faktiskt kan åstadkomma nu med de bästa och största AI-modellernas API:er som det finns fördefinierade gränssnitt för i iMatch Autotagger.

Den molntjänst som använts i detta fall är Open AI API för GPT 5.2 som just släppts unden december 2025.

Inget kan idag mäta sig med Open AI och Google Gemini.

Jag har testat även franska Mirage AI 3.1 men den håller i dessa fall inte alls samma klass och ger klart sämre resultat.

Jag har alltså autogenererat bildbeskrivningar i detta fall för två typer av bilder och deras s.k. "Descriptions".

Bilderna är rakt ut ur iMatch AS IS och har inte editerats eller rättats.

Detta för att ni ska kunna få en uppfattning om vad man faktiskt kan göra och vilken kvalitet man kan få på texterna.

AI-genererade texter blir inte bättre än prompningen - principen som man frågar för man svar gäller.

För att generera AI-texterma (160 stycken) och skapa två Portfolios och läsa in bilderna samt skapa denna tråd på FS så har jag lagt ner ca två timmar.

Om jag skulle gjort detta manuellt vilket man måste i exv. PhotoMechanic, som många fotografer använder, så hade det nog tagit dagar att få till dessa texter och jag hade aldrig orkat skapa texter med den kvalitet som Autotagger och Open AI faktiskt får till med hyfsat god promptning. Jag har ju heller inte de kunskaper som ligger bakom speciellt texterna kring arkitekturen.

Nedan kan ni se hur den prompt ser ut som jag förfinat fram till idag.

Som ni kan se i bildtexterna i de två portfolios jag skapat med exempelbilder, så kan man göra ganska avancerade saker numera i version 5.2

Redan i "blindtester" man nu gör och hittills gjort med GPT 5.2 visar att kvaliteten på det som kommer ur GPT 5.2 ger bättre resultat än om människor skulle gjort arbetena och det går verkligen på bråkdelar av den tid människor skulle klarat av samma jobb på.

I en studie i dagarna nere från Lund så hittade AI-bildtolkning av röntgenbilder tagna på patienter cancer i betydligt fler fall än tränad specialiserad personal lyckades göra och i tidigare stadier av sjukdomen.

Min egen frus cancer missades under ca ett år, vilket ledde till tre stora och mycket besvärliga canceroperationer. Vem vet, all dessa kanske aldrig skulle behövt genomföras om AI-diagnosticering funnits för fem-sex år sedan.

Åter till ämnet:

Längst ned i bildtexterna i varje ser ni en sammanfattning och det som skrivits där kommer från variabler AI har befolkat med text.

Jag har även formaterat texten med tomrader for att öka läsbarheten.

När man ser formatteringen i iMatch så visas texten som nedan:

Även i min RAW-konverterare Photolab 9 behålls formateringen från iMatch perfekt, vilket gör texten betydligt mer läsbar:

I Portfolios så tas alla line feeds bort så allt ligger i en enda röra igen.

Den fösta länken går till en Portfolio jag skapat här på FS som heter "Global Architecture":

Den innehåller ca 60 bilder med arkitekturexempel från ett antal länder.

Den andra länken går till en Portfolio med "Animals and Plants from East-Africa"

Den innehåller ca 100 bilder med djur och växter.

Animals and Plants in East-Africa - A test of iMatch AI-generated Descriptions

Animals and Vegetation in East Africa - Zanzibar Tanzania 2016 - A roller bird is perched on a thick, gnarled tree branch. The bird?s plumage is a striking combination of blue-green feathers across its body and wings, contrasted by a warmer brown head and neck. It appears alert and watchful...

sten-ake-sandh.fotosidan.se

I de tester jag gjort med Open AI GPT 5.2 på djur och växt motiv, ca 150 bilder, så fick jag en felprocent på ca 8% sist jag kollade. Det är mycket bra om man jämför med exv. Mistral 3.1 som annars har hyfsat rykte. Dock är Mistral inget bra val idag för att märka upp djur och växtbilder med. Där går den tjänstens gräns för användbarhet.

När det gäller arkitekturbilderna så hade jag förväntat mig mer av Open AI när det gäller "Landmarks". Jag är säker på att Google Gemini 3 eller Flash 2.5 hade klarat "Landmarks" och miljöer bättre. Så varje AI-tjänst har sina egenheter.

OBS!!! De bilder som nu finns under dessa två länkar oven är utbytta mot nya bilder som skapats med den gratis AI-källan Google Gemma 3 12b som körts på den gratis AI-plattformen Ollama. Detta för att testa om det möjligen kan vara möjligt att slippa köra över och vara beroende av de stora amerikanska molntjänsterna Google Gemini och Open AI.

En tidigare mindre modell (Gemma 3 4b) som jag var tvungen att köra då mitt tidigare grafikkort med 8GB VRAM inte klarade den större modellen, klarade INTE att artbestämma djur och växter på dessa bilder. Så hittills har jag för det kört Open AI API medd iMatch DAM.

Glädjande är nu att Gemma 3 12b visar riktigt bra resultat både med att beskriva och klassificera arkitektur och att artbestämma djur och växter men kräver alltså minst 16 GB VRAM. Detta är viktigt att påpeka då priset för de nya 16GB-korten ligger upp mot 10 000, så för många kommer det vara utom räckhåll och då är enda alternativet att köra molntjänsterna som kräver mycket mindre av lokal dator.

Description Prompt i Autotagger

[[-c-]]

General instruction:

Always priority for geografic data in the first line and than add a space, the year the picture is taken and peoples names.

{File.Persons.Label.Confirmed|hasvalue:These persons are shown in this image: {File.Persons.Label.Confirmed}.}

Always write text inside quotes but without the quote signs.

Always translate and write texts on signs into English.

Describe picture in a casual and vivid style.

Use simple English, common words, factual language, and simple sentences.

Avoid describing anything not directly observable in the image.

Always write the Description in 3 paragraphs.

Separate paragraphs with a blank line (i.e., exactly two line breaks between paragraphs).

Do not use bullet lists.

Animal section:

If animals in picture always include a description of the animals appearance, habitat, diet, behaviors, and any unique characteristics.

Consider adding notable facts or interesting trivia about this species. Always add space before

If there is an animal, flower or plant in the image, write the animal’s, flower's or plant's common name, family name, and scientific (Latin) name in the format below and always as the last three lines of text – after the space:

Species common name: [Species common name]

Family: [Family name]

Scientific name: [Latin name]

Else never write anything you don´t see in the picture. Return nothing.

Achitecture section:

If there is architecture in the picture:

Describe the architectures characteristics with an architects professional concepts even important details of facades elements e.t.c. and the time when it was most popular

End with – after a space:

Architecture type or style: [Architecture style or Architecture type]

Senast ändrad: